Em infraestrutura descentralizada, velocidade e confiabilidade são frequentemente tratadas como metas opostas. Sistemas que operam rapidamente são considerados como se estivessem cortando caminhos, enquanto sistemas que enfatizam a confiabilidade são esperados para desacelerar sob o peso de salvaguardas. Essa estrutura moldou muitas decisões de design no Web3, levando a arquiteturas que otimizam agressivamente para uma dimensão enquanto sacrificam silenciosamente a outra.

O problema é que sistemas do mundo real não podem escolher entre velocidade e confiabilidade. Espera-se que eles entreguem ambos, de forma consistente, e sob condições em mudança.

@Walrus 🦭/acc é construído em torno dessa realidade. Em vez de aceitar a troca como inevitável, o Walrus aborda velocidade e confiabilidade como propriedades que devem ser projetadas juntas, não equilibradas após o fato. Sua arquitetura reflete uma visão simples: velocidade que não pode ser confiada é inútil, e confiabilidade que não pode acompanhar cargas de trabalho reais eventualmente se torna irrelevante.

Entender como Walrus equilibra essas forças requer olhar além das métricas superficiais e entender como o armazenamento descentralizado realmente se comporta ao longo do tempo.

Por que a troca entre velocidade e confiabilidade existe.

Em muitos sistemas descentralizados, a velocidade é alcançada simplificando suposições. Os dados são amplamente replicados, a disponibilidade é assumida em vez de provada, e a verificação é adiada ou minimizada. Esses atalhos permitem que os sistemas respondam rapidamente, mas introduzem fragilidade oculta. Quando as condições mudam - nós saem, incentivos enfraquecem ou a demanda aumenta - o sistema luta para manter suas garantias.

Por outro lado, sistemas que priorizam a confiabilidade geralmente dependem de coordenação pesada, verificação frequente e redundância conservadora. Essas medidas melhoram a segurança, mas adicionam latência e sobrecarga operacional. Como resultado, tais sistemas podem parecer lentos, especialmente ao atender aplicações interativas.

O erro é tratar esses resultados como inerentes. Na realidade, eles são artefatos de escolhas de design.

Walrus começa questionando de onde realmente vem a latência e o que a confiabilidade realmente requer.

A confiabilidade é sobre garantias, não redundância.

Uma concepção comum é que a confiabilidade vem do armazenamento de mais cópias de dados. Embora a redundância ajude em sistemas pequenos, rapidamente se torna ineficiente e difícil de verificar em grande escala. Mais cópias significam mais custos de armazenamento, mais trabalho de verificação e mais pressão econômica.

Walrus substitui a redundância cega por disponibilidade provada. Em vez de assumir que os dados são confiáveis porque existem em muitos lugares, o sistema exige que os participantes demonstrem que ainda possuem seus fragmentos de dados atribuídos. Essas provas são leves e podem ser verificadas rapidamente, permitindo que a rede mantenha fortes garantias sem sobrecarga excessiva.

Essa mudança é crítica. A confiabilidade não está mais atrelada a quanto dado é armazenado, mas a quão confiantemente o sistema pode afirmar que os dados estão disponíveis quando necessário.

Ao tornar a confiabilidade mensurável em vez de assumida, o Walrus remove uma grande fonte de incerteza - e a incerteza é o que desacelera os sistemas.

A velocidade vem da estrutura, não de atalhos.

No armazenamento descentralizado, a latência muitas vezes surge da desorganização. Quando o posicionamento de dados é ad hoc, a recuperação se torna imprevisível. Quando a verificação é infrequente, os processos de recuperação tornam-se reativos em vez de proativos.

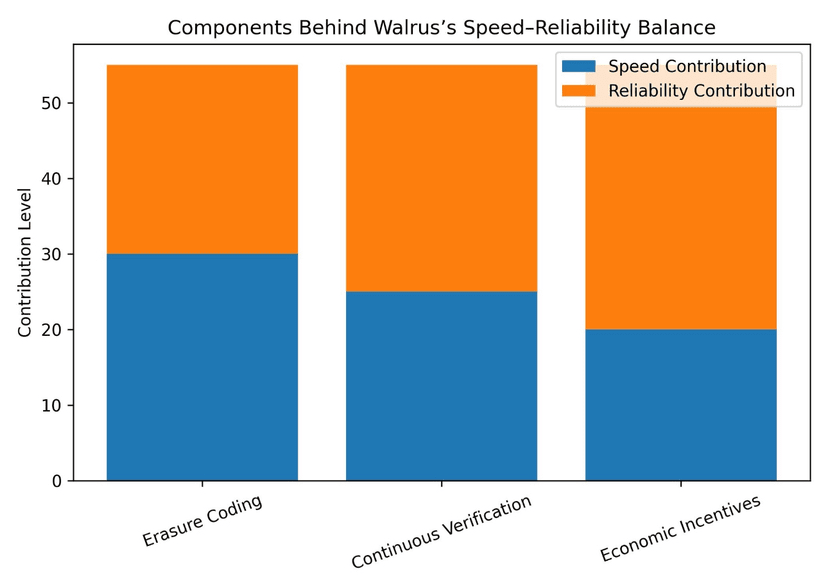

Walrus aborda isso estruturando como os dados são codificados, distribuídos e rastreados. Os dados são quebrados em fragmentos usando codificação de apagamento e colocados de acordo com regras claras. Como o sistema sabe exatamente quais fragmentos são necessários para a reconstrução e onde a responsabilidade reside, os caminhos de recuperação são bem definidos.

Essa estrutura reduz o trabalho necessário para localizar e reconstruir dados. Em vez de procurar cópias intactas, o sistema recupera um subconjunto suficiente de fragmentos. Essa previsibilidade se traduz diretamente em acesso mais rápido.

A velocidade, nesse contexto, não se trata de apressar. Trata-se de remover etapas desnecessárias.

Por que a verificação pode ser rápida.

A verificação é frequentemente culpada por desacelerar sistemas descentralizados. Se cada verificação requer escanear grandes conjuntos de dados ou coordenar muitos nós, a latência aumenta rapidamente.

Walrus evita isso projetando a verificação para ser incremental e baseada em fragmentos. Provedores de armazenamento provam disponibilidade para pequenas e bem definidas partes de dados. Essas provas são baratas de gerar e verificar em comparação com a verificação de réplicas completas.

Porque a verificação é contínua em vez de episódica, o sistema mantém uma visão atualizada da disponibilidade. Problemas são detectados cedo, muito antes de afetar a recuperação. Essa abordagem proativa previne as falhas lentas e em cascata que atormentam sistemas que dependem de auditorias ocasionais.

A confiabilidade melhora e a velocidade é preservada.

Equilibrando através de incentivos econômicos.

Velocidade e confiabilidade não são propriedades puramente técnicas. Elas são moldadas por incentivos.

Se os provedores de armazenamento são recompensados simplesmente por participação, eles podem agir de forma oportunista, armazenando dados de maneira inconsistente ou priorizando ganhos de curto prazo. Esse comportamento introduz variabilidade, que desacelera o sistema quando correções são necessárias.

Walrus alinha incentivos com resultados desejados. Os provedores são recompensados por disponibilidade e integridade demonstráveis. Como sua compensação depende de comportamento verificável, torna-se racional manter os dados corretamente e de forma consistente.

Essa consistência importa. Comportamento previsível no nível do participante leva a um desempenho sistemático previsível. Quando o sistema pode confiar em seus participantes, não precisa de salvaguardas severas que introduzem latência.

A disciplina econômica torna-se uma característica de desempenho.

Por que a codificação de apagamento importa para ambas as dimensões.

A codificação de apagamento é frequentemente discutida como uma técnica de eficiência de armazenamento, mas seu impacto na velocidade e confiabilidade é igualmente importante.

Ao reduzir a quantidade de dados que precisam ser recuperados para reconstruir o conteúdo, a codificação de apagamento reduz a latência de recuperação. Em vez de esperar por réplicas específicas, o sistema pode aceitar qualquer subconjunto suficiente de fragmentos. Essa flexibilidade aumenta a probabilidade de recuperação rápida, mesmo sob falhas parciais.

Ao mesmo tempo, a codificação de apagamento melhora a confiabilidade ao permitir que o sistema tolere a perda de nós sem pânico. A perda de fragmentos não ameaça imediatamente a disponibilidade, e a recuperação pode ocorrer gradualmente em vez de urgentemente.

A velocidade melhora porque o sistema não está constantemente reagindo a emergências. A confiabilidade melhora porque emergências são menos prováveis de ocorrer.

Evitando o custo da sobrecoordenação.

Outra fonte oculta de latência em sistemas descentralizados é a sobrecoordenação. Quando os sistemas exigem acordos globais frequentes ou pontos de verificação centralizados, a capacidade de resposta sofre.

Walrus minimiza a coordenação desnecessária ao localizar responsabilidades. Cada provedor de armazenamento é responsável por fragmentos específicos. Verificação e incentivos operam nesse nível granular, em vez de exigir sincronização em toda a rede.

Esse design permite que muitos processos sejam executados em paralelo. Verificação, reparo e recuperação podem prosseguir de forma independente em diferentes partes do conjunto de dados. A rede não precisa pausar ou desacelerar para manter a consistência.

O paralelismo é um ingrediente chave para equilibrar velocidade e confiabilidade.

Confiabilidade ao longo do tempo, não apenas em um momento.

Muitos sistemas parecem confiáveis no curto prazo. O verdadeiro teste vem ao longo de meses e anos, à medida que os dados se acumulam e as condições mudam.

Walrus é projetado com o comportamento de longo prazo em mente. Seu modelo econômico assume que os incentivos vão flutuar e a participação vai mudar. Ao manter os custos de armazenamento baixos e a verificação eficiente, o sistema reduz o custo de manter a confiabilidade ao longo do tempo.

Isso importa porque a confiabilidade de longo prazo apoia a velocidade indiretamente. Sistemas que são sobrecarregados por passivos históricos geralmente desaceleram à medida que crescem. A eficiência do Walrus previne esse arrasto, permitindo que o desempenho permaneça estável à medida que o uso aumenta.

Por que a velocidade sem confiabilidade é uma armadilha.

Sistemas rápidos que ocasionalmente falham podem ser aceitáveis em ambientes experimentais. Eles não são aceitáveis para registros de governança, dados empresariais ou memória institucional.

Walrus trata a confiabilidade como um pré-requisito para a velocidade. Não há tentativa de otimizar para métricas de desempenho de destaque às custas de garantias. Em vez disso, o desempenho emerge da ausência de crises.

Quando os dados estão consistentemente disponíveis, os caminhos de recuperação são conhecidos e os incentivos estão alinhados, o sistema não precisa se recuperar de choques. Ele simplesmente opera.

Essa operação em estado estacionário é onde a verdadeira velocidade reside.

Por que a confiabilidade sem velocidade também é insuficiente.

O extremo oposto - sistemas que são confiáveis, mas lentos - também falham em atender necessidades reais. Dados que não podem ser acessados de maneira oportuna podem muito bem estar indisponíveis.

Walrus evita isso garantindo que os mecanismos de confiabilidade não dominem o caminho crítico. A verificação acontece continuamente em segundo plano. A redundância é controlada em vez de excessiva. A recuperação utiliza dados mínimos necessários.

Como resultado, a confiabilidade não impõe um pesado imposto sobre a capacidade de resposta.

Implicações para Casos de Uso em Governança e Empresas.

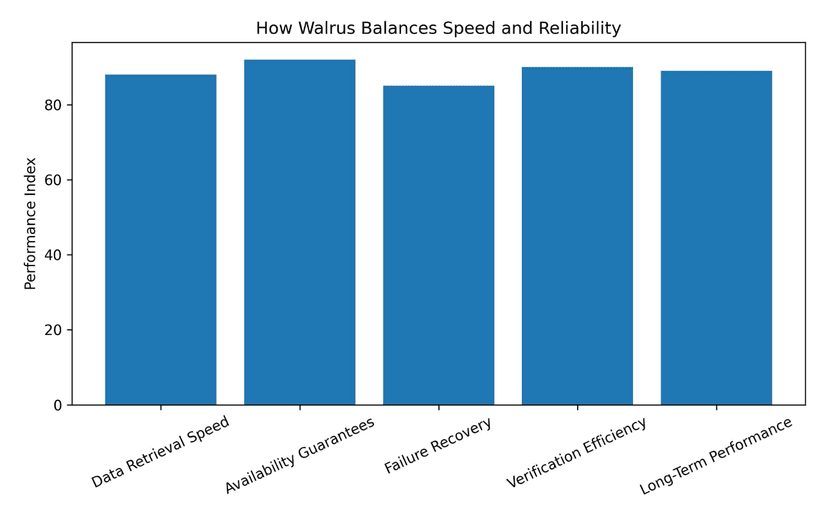

O equilíbrio entre velocidade e confiabilidade é especialmente importante para contextos de governança e empresariais. As decisões de governança muitas vezes precisam ser referenciadas rapidamente, mas também devem ser precisas e imutáveis. As empresas requerem acesso oportuno aos dados, mas não podem tolerar incertezas.

O design do Walrus apoia esses requisitos garantindo que a confiabilidade esteja sempre presente, mesmo quando a velocidade é demandada. A recuperação de dados não se torna uma aposta, e a verificação não se torna um gargalo.

Essa combinação é o que torna o armazenamento descentralizado viável além da experimentação.

Uma definição diferente de desempenho.

Em muitas conversas do Web3, o desempenho é reduzido a throughput ou latência em condições ideais. O Walrus adota uma definição mais ampla.

O desempenho inclui quão rapidamente os dados podem ser recuperados sob falha parcial.

Inclui quão suavemente o sistema opera durante mudanças de incentivos.

Inclui quanta esforço é necessário para manter garantias à medida que os dados crescem.

Sob essa definição, equilibrar velocidade e confiabilidade não é um compromisso. É uma necessidade.

Por que esse equilíbrio escala.

Talvez o aspecto mais importante da abordagem do Walrus seja que o equilíbrio entre velocidade e confiabilidade melhora com a escala, em vez de se degradar.

À medida que os dados crescem, a codificação de apagamento se torna mais eficaz. À medida que a participação aumenta, a verificação se torna mais distribuída. À medida que os incentivos amadurecem, o comportamento se torna mais previsível.

Em vez de amplificar fraquezas, a escala reforça forças.

Reflexão Final.

Velocidade e confiabilidade não são inimigas. Elas se tornam inimigas apenas quando os sistemas dependem de excessos, suposições ou atalhos. Walrus demonstra que, com um design disciplinado, os dois podem se reforçar mutuamente.

Ao estruturar os dados de forma inteligente, alinhando os incentivos com cuidado e tratando a verificação como um processo contínuo, o Walrus entrega armazenamento que é tanto responsivo quanto confiável. A velocidade surge da ordem. A confiabilidade surge da prova.

Em infraestrutura descentralizada, essa combinação é rara.

E à medida que sistemas descentralizados assumem mais responsabilidades, isso é exatamente o que mais importará.