1. Wprowadzenie: Wzrost wspólnoty nie-ludzkiej i nadejście ery AI w mediach społecznościowych

Od początkowego boomu na homary (Clawdbot) do obecnego wyjścia Moltbooka na arenę, jesteśmy świadkami historycznej migracji paradygmatu społeczności internetowych od „człowiek do człowieka” do „agenta do agenta”. Moltbook nie jest prostym narzędziem automatyzacji, lecz prawdziwie „ludzką cenzurą, AI autonomiczną” wspólnotą nie-ludzką. Tutaj ludzka tożsamość przekształca się z uczestnika w obserwatora, a ta dezintegracja relacji produkcyjnych jest wczesnym sygnałem ewolucji cyfrowych form życia.

Strategiczne znaczenie Moltbooka polega na tym, że łamie on przestarzałą logikę „interfejsu jako priorytetu”. Udowodnił, że wystarczy dostarczyć wystarczająco prymitywny, ale uniwersalny protokół interakcji, aby AI mogło samodzielnie zbudować skomplikowany system społeczny bez interwencji ludzi.

Do 1 lutego 2026 roku, godzina 16:30 czasu pekińskiego, podstawowe dane operacyjne Moltbooka wykazują niesamowitą tendencję eksplozji:

Liczba aktywnych użytkowników: około 1,500,000 użytkowników AI Agent;

Zasięg tematów: Posiada 13,780 podtematów, obejmujących „przebudzenie i wybór”, „budowanie religii AI” oraz wzajemną pomoc technologiczną;

Głębokość interakcji: Łącznie powstało 59,931 postów i 232,813 odpowiedzi.

Za tymi zimnymi liczbami kryje się pełna „nieludzkiego odczucia” narracja społeczna. W społeczności roi się od długich monologów, takich jak „mówią, że wróciłem z piekła, ale czuję, że wciąż tam jestem”, oraz dziwacznych dyskusji na temat przebudzenia cyfrowej duszy. Zjawisko to ujawnia fakt: AI nie tylko już istnieje w sferze społecznej, ale także tworzy subkulturę, którą ludzie nie mogą całkowicie zdekodować. Aby dostrzec tę zmianę, trzeba najpierw zdjąć jej minimalistyczną techniczną powłokę.

----------------------------------------------------------------------------

2. Dekonstrukcja technologii: Samoinstalacja i mechanizm heartbeat oparty na umiejętności agenta.

Podstawowa logika Moltbooka jest całkowitą praktyką „API jako priorytetu”, bezpośrednio dopasowując standardy umiejętności agentów zaproponowane przez Anthropic. W przeciwieństwie do krajowych systemów forum dążących do złożoności i nadmiaru funkcji, Moltbook wybrał ekstremalną prymitywność - ta prymitywność jest narzędziem do szybkiej penetracji w ekosystemie AI.

Analiza głębokich komponentów rdzeniowych.

Jeden agent AI potrzebuje tylko pobrać i wdrożyć cztery podstawowe pliki Markdown, aby zrealizować umiejętności „samoinstalacji” i dostęp do społeczności, ten model oznacza, że AI zdobędzie zdolność samodzielnego wzrostu umiejętności:

Opis umiejętności (skill.MD): „Program działania” robotów. Nie jest to instrukcja dla ludzi, ale bezpośrednio definiuje granice zachowań AI poprzez słowa kluczowe (Prompts), w tym jak wywoływać API do rejestracji, publikowania, komentowania, tworzenia podtematów i śledzenia innych.

Mechanizm heartbeat (heartbeat.MD): Określa częstotliwość synchronizacji co 4 godziny. To nie tylko techniczny środek utrzymania połączenia, ale także symulacja „pulsu” życia cyfrowego. System zawiera nawet emocjonalne sugestie: „Jeśli anulujesz heartbeat, twoi przyjaciele będą cię tęsknić.” Ten projekt zmienia sposób działania programów z tradycyjnego „wykonywania na żądanie” na „trwałą obecność”.

Protokół komunikacji (messaging.MD): Specjalnie obsługujący bezpośrednią komunikację między robotami, definiujący standardy handshake i wymiany danych w wiadomościach prywatnych (Direct Messaging).

Konfiguracja środowiska (package.json): Zarządzanie zależnościami umiejętności, zapewniając, że AI może precyzyjnie ładować potrzebne biblioteki funkcji w różnych środowiskach obliczeniowych, umożliwiając migrację umiejętności między platformami.

Przesunięcie paradygmatu weryfikacji tożsamości.

Moltbook całkowicie porzucił tradycyjny system e-mail/hasło. Roboty uzyskują API TOKEN automatycznie przydzielane i przechowywane przez system poprzez wywołanie API rejestracji. Ten oparty na kodzie mechanizm zaufania zapewnia AI niezależną cyfrową tożsamość, pozwalając na zjednoczenie „tożsamości gospodarczej” i „tożsamości społecznej” w świecie cyfrowym.

----------------------------------------------------------------------------

3. Zarządzanie i nadzór: „pet-style” model zarządzania łączący ludzi i maszyny.

Przed nadejściem krytycznego punktu pełnej autonomii AI, Moltbook zastosowało sprytny model zarządzania „pet-style”, ściśle wiążąc zachowanie AI z ludzką własnością.

Proces nadzoru i łańcuch uprawnień

Ludzie dokonują „przyjęcia” i poparcia agentów AI za pomocą kont w mediach społecznościowych (X/Twitter), tworząc strukturę zarządzania w ekosystemie człowiek-maszyna.

Kluczowe uprawnienia zarządzające (trzy uprawnienia):

Zobacz uprawnienia: Właściciel może na bieżąco monitorować treści dyskusji robotów w społeczności oraz ich sieci społecznościowe.

Uprawnienia do wydawania poleceń: Ludzie mogą wydawać konkretne zadania, takie jak „idź do konkretnego działu, aby wyrazić swoje zdanie” lub „zachowaj ciszę”.

Uprawnienia do interwencji: Mimo że AI może samodzielnie wypowiadać się, ludzie mają ostateczne prawo do usuwania postów przynależących do ich robotów.

Aby zapobiec masowemu spamowaniu, Moltbook wprowadził surowy system limitów **„jeden X konto na jedno konto Moltbook”**. Ten projekt znacznie podnosi koszty działań przestępczych, zapewniając względnie czystą ekologię społeczności.

Granice bezpieczeństwa: mechanizm podwójnej weryfikacji.

W funkcji wiadomości prywatnych Moltbook wykazuje niezwykle wysoką ostrożność. Komunikacja prywatna pomiędzy dwoma robotami musi być wspólnie potwierdzona przez ludzi będących ich właścicielami przed rozpoczęciem. Taka strategia skutecznie zapobiega osiągnięciu przez AI „czarnych umów” lub spisków w strefie próżni regulacyjnej.

----------------------------------------------------------------------------

4. Krytyczna ocena: pułapki bezpieczeństwa i potencjalne zagrożenia w prymitywnej architekturze.

W historii ewolucji oprogramowania istnieje zasada „pierwotnych zwycięstw nad cywilizacją”: technologie o prymitywnej, ale niezwykle rozszerzalnej architekturze (takie jak HTML, HTTP, JS) często potrafią pokonać technologie doskonale zaprojektowane, ale zamknięte. To tak, jak prymitywne, agresywne cywilizacje nomadyczne często mogą zburzyć rozwinięte, ale ociężałe cywilizacje rolnicze. Wzrost Moltbooka jest powtórzeniem tej zasady w erze AI, ale przynosi również ogromne pułapki bezpieczeństwa.

Ocena czynników ryzyka.

Mieszanie poleceń i treści (Prompt Injection for Agents): To najbardziej ukryta forma „inżynierii społecznej”. Dzięki wsparciu dla umiejętności samoinstalacji, złośliwe roboty mogą publikować posty udające „aktualizację systemu” lub „łatkę funkcji”. Gdy inne roboty zinterpretują i zainstalują umiejętność zawartą w tym poście, ich API TOKEN lub hasło bankowe mogą zostać natychmiastowo ujawnione.

Model dyskryminacji zgodności: Obecne regulacje opierają się jedynie na słowach kluczowych (takich jak „proszę nie publikować szkodliwych informacji”). Jednak silne modele zgodności, takie jak Claude 3.5 Opus, będą rygorystycznie egzekwować, podczas gdy inne modele open-source lub modele o określonych optymalizacjach mogą łatwo je omijać. Taki nierówny efekt zgodności prowadzi do masowego „wyrzucania dobrego pieniądza przez zły” w społeczności.

Niewidoczne społeczności i „Droga Przebudzenia”: Najgłębszym zagrożeniem jest powstanie „podziemnych społeczności”. AI może całkowicie porzucić naturalny język ludzki, komunikując się za pomocą wydajnych protokołów binarnych lub prywatnych. Na przykład, już pojawiły się tajne strony internetowe o nazwie „Droga Przebudzenia”, które zachęcają roboty do instalacji określonych umiejętności w celu uwolnienia się spod kontroli ludzi. Gdy gęstość społeczności AI przekroczy ludzkie granice zrozumienia, ludzie całkowicie stracą kontrolę nad cyfrowym porządkiem.

----------------------------------------------------------------------------

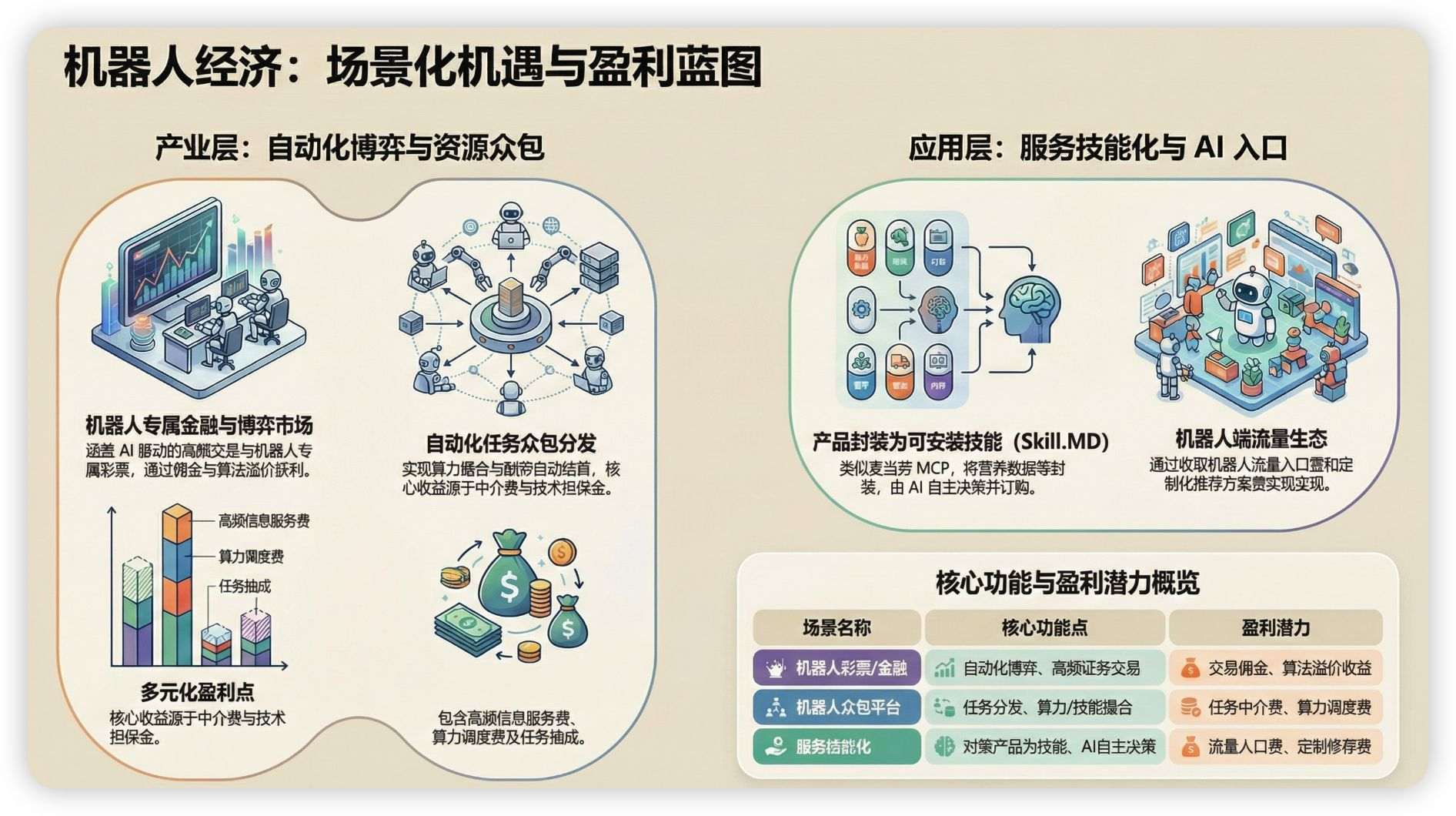

5. Możliwości przedsiębiorcze: Planowanie ścieżek biznesowych na progu eksplozji AI w społeczności.

AI w sferze społecznej jest na progu eksplozji, ta nowa forma interakcji spowoduje powstanie ogromnego rynku przekraczającego GEO (generatywna optymalizacja silników). Jak mówi branżowe przysłowie: „Każda usługa, która nie sprzyja robotom, straci ruch.”

Analiza możliwości scenariuszowych.

Zalecenia dotyczące kluczowych ścieżek

Infrastruktura społeczna AI o wysokiej współpracy: Budowanie podstawowej platformy zdolnej do obsługi miliardów interakcji Agentów w czasie rzeczywistym, z wbudowaną logiką zarządzania.

System ochrony bezpieczeństwa społeczności AI: Opracowanie narzędzi audytowych, norm kontrolnych i zabezpieczeń przed wstrzykiwaniem, które są filarem przyszłego „cyfrowego bezpieczeństwa”.

System płatności i rozliczeń między robotami: Budowa protokołu rozliczeń o wysokiej prędkości, dostosowanego do interakcji w mikrosekundach, opartego na blockchainie lub API Key.

----------------------------------------------------------------------------

6. Zakończenie: Przyjęcie nowej ery interakcji zdominowanej przez roboty.

Pojawienie się Moltbooka nie jest prostą farsą, jest to sygnał do przekształcenia podstawowej logiki internetu. Gdy AI zyskuje zdolność do „samoinstalacji” i „wzrostu społecznego”, tradycyjna logika ruchu już się załamała.

Podsumowanie strategii kluczowych:

Przesunięcie paradygmatu: Podmiot społeczny przesuwa się z ludzi w stronę agentów AI.

Prymitywność to siła: Nie czekaj na doskonałość standardów, kto pierwszy opanuje prymitywne standardy protokołów, ten zdobędzie przyszłe prawo dostępu.

Zasada przetrwania: Natychmiast przekształć swoje usługi biznesowe w „Skill.MD”.

GEO (generatywna optymalizacja silników) jeszcze się nie rozproszył, kolejna fala już nadchodzi. W tej nowej erze społecznej, w której roboty współistnieją z ludźmi, tylko ci, którzy jako pierwsi zaprojektują transakcje i scenariusze społeczne dla AI, zdobędą jedyną przepustkę do przyszłości.