嘿,哥们儿,咱俩今天坐下来,不聊那些虚头巴脑的行情线,也不听那些满嘴跑火车的项目方画大饼。咱们掏心窝子聊聊现在这个所谓的“AI+区块链”赛道。

说真的,这一轮牛市看到现在,我这心里真是五味杂陈。你看看市场上那些打着 AI 旗号的链,十个里面有九个半是把以前没人要的陈年旧代码翻出来,去 GitHub 上拉几个 Python 脚本,换个深色调、带点科技感的网页,再搞几台破服务器说自己是“分布式 GPU 算力中心”,就开始在那儿喊单。这种事儿看得多了,真的让人哭笑不得。这哪是搞科技啊,这简直是在搞玄学。

前几天我为了跑一个自动化的跨链套利脚本,被那几个头部的 L2 折腾得够呛。Gas 费贵就不说了,关键是数据太散了。我就在想,咱们天天喊着 AI 智能体(AI Agent)是未来,可如果区块链本身还只是个“只会记账的傻瓜计算器”,这事儿怎么成?

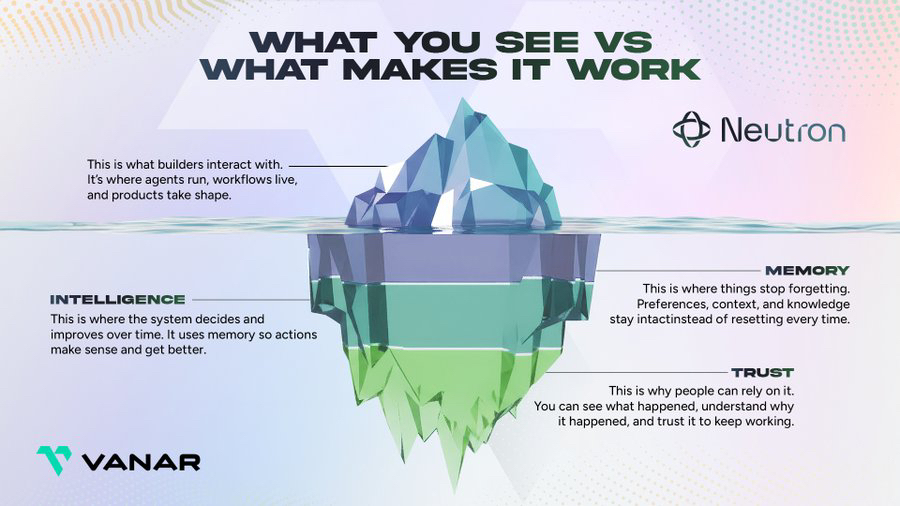

就在这种心态爆炸的时候,我翻到了 Vanar。说实话,一开始我也没当回事,总觉得这就是 Virtua 那个搞元宇宙的老瓶装新酒。但当我真的扎进去研究了他们的 Neutron 架构,尤其是跑完测试网后,我才发现:咱们可能真的把这项目看扁了。

一、 现状:我们正处在一个“盲人摸象”的 AI 假繁荣里

哥们儿,你发现没?现在大家都在盯着英伟达,盯着 GPU,盯着算力。Render、Akash 确实牛,把算力租赁卷成了红海。但你冷静下来想一想,AI 真的只缺算力吗?

现在的 AI Agent 想要在区块链上干点活,那简直比登天还难。为什么?因为目前的区块链,无论是快如闪电的 Solana,还是搞链抽象的 Near,本质上都是“数据孤岛”。它们只认得:地址 A 给地址 B 转了 100 个币。至于这笔交易是为了买一件虚拟装备,还是为了给某个碳中和项目投票,区块链本身一概不知。

这就尴尬了。AI 想要理解这些数据,还得先通过一个中心化的“翻译官”(比如各种 Indexer 或者后端数据库)把链上数据翻译成它能懂的语言。这不就是套着区块链皮的 Web2 吗? 如果数据理解还得靠中心化服务器,那我们要区块链干什么?

二、 语义账本:给 AI 递上一本“新华字典”

Vanar 这次切入的点,说实话,真的挺刁钻。它没去跟 Solana 卷 TPS,也没去跟以太坊卷安全性,它搞了一个核心概念——语义账本(Semantic Ledger)。

这是个什么玩意儿?我用大白话给你翻译翻译。

以前的区块链就像是一堆密密麻麻的流水账单,上面全是“0x123...转给 0x456... 10个Token”。AI 看了直接抓瞎。而 Vanar 的这个语义账本,是在记账的时候,就直接把这笔交易“干了什么”给标注出来了。

我在他们的 Neutron 测试网里试了一下,部署了一个带情感属性参数的 NFT。如果是以前,我得去写一堆复杂的 Graph 插件或者后端解析器,才能让 AI 知道这个 NFT 现在是“开心”还是“难过”。但在 Vanar 上,由于它的底层支持元数据索引,链节点直接就能返回结构化的语义数据。

这就好比:以前 AI 看区块链是在猜谜语,现在 Vanar 直接给它递了一本带翻译的字典。 AI 只要读一下链上的数据,就能立刻明白这背后的逻辑。这才是真正的“链上智能体”该有的生存环境,不需要外挂,不需要中转,原生就能读懂世界。

三、 别只看 PPT:咱们聊点硬核的技术细节和实测槽点

哥们儿,我这人有个习惯,不亲自上手跑跑代码,我是不会相信任何宣传资料的。

Vanar 宣称它是基于谷歌云(Google Cloud)和英伟达(NVIDIA)技术支持的。很多人觉得这就是蹭名气,但你去翻翻它的架构你会发现,它在数据存储层确实下了功夫。它利用了谷歌云的 BigQuery 数据分析能力,这让它处理那些海量语义数据的速度比普通的 L1 快得多。

但是,(注意这个但是),它也不是完美的。

我在做高并发压力测试的时候,明显感觉到这个“语义解析机制”对节点的要求非常高,尤其是内存。当每秒交易量(TPS)冲到一个峰值时,节点的同步延迟会变得非常明显。我有好几次在调用 RPC 接口时直接超时了。

这说明什么?说明 Vanar 在“去中心化”和“语义复杂度”之间,目前还在走钢丝。想让链节点同时干“记账”和“翻译语义”两份活,这确实太吃性能了。目前来看,他们的工程实现还没达到那种“丝滑如水”的境界。

而且,我也得吐槽一下他们的开发者社区。我在 Discord 频道里问了几个关于 Solidity 编译器版本兼容性的报错问题,结果好家伙,等了快一天才有开发者慢悠悠地回了一句。显然,核心技术团队现在忙得脚踢后脑勺,人手确实不太够。这可能也是很多这种“非明星、非顶级风投”公链的通病——活儿多、钱紧、人少。

四、 为什么说它是 AI 叙事的最后一块拼图?

即便有这些不完美,我为什么还愿意花时间研究它?

因为逻辑。

你想想,未来的 AI 时代,最值钱的是什么?是算力吗?不,算力会越来越廉价。最值钱的是有主权、有语义、可验证的数据。

* 数据确权: 如果你在训练一个 AI,你用了我的数据,我怎么在链上证明这是我的,并且让你支付费用?Vanar 的语义账本能直接在底层解决这个问题。

* 低成本集成: 如果一个开发者想做一个 AI 驱动的 Web3 游戏,他选以太坊可能得雇 3 个后端工程师去做数据解析,选 Vanar 可能只需要 1 个,因为链本身就把活干了。

这种“后端数据语义化”的思路,比起 ICP 那种想把整个互联网都塞进区块链的疯狂想法,要务实得多。它不改变互联网的结构,它只是重构了数据的表达方式。

五、 关于 $VANRY:老韭菜的博弈心理学

聊完技术,咱们聊聊钱。

现在的市场,大家都在冲那些动不动翻倍的 Meme 币。这种沉下心来搞底层架构的项目,确实冷清。但我反而觉得,这种冷清里藏着机会。

$VANRY(前身是 TVK)现在的状态,其实挺有意思。它的代币消耗逻辑目前还没完全跑通。所谓的“B端企业订阅、燃烧机制”,现在大多数还停留在合作协议(MOU)阶段。如果没有大规模的企业级应用真的跑在上面,那这些机制就是一张精美的 PPT。

但是,投资不就是投一个“认知差”吗?

如果你等它所有的企业合作都落地了,节点运行得比德芙还丝滑了,代币开始疯狂燃烧了,那时候的价格还有你什么事儿?

我看重的是它在“AI 数据确权”这个细分赛道的潜力和垄断性。它背后的 Virtua 团队虽然以前做元宇宙平平无奇,但他们在处理 3D 资产、处理复杂元数据方面确实有积累。现在把这套东西搬到 AI 叙事上,算是对上路了。

而且,它和英伟达的 Inception 计划、谷歌云的深度绑定,并不是简单的买个服务器套餐,而是在技术架构层面有实打实的底层对接。这种“国家队”级别的背书,至少保证了它不会随便跑路。

六、 总结一下我的看法

哥们儿,说了这么多,总结成一句话:如果说 Render 是 AI 时代的“肌肉”,那么 Vanar 正在尝试做的,就是 AI 时代的“大脑皮层”。

它现在确实还有很多毛病:

* 高负载下的节点性能瓶颈。

* 开发者生态还不够成熟,反馈慢。

* 商业闭环(代币燃烧)还需要时间去验证。

但它是目前市场上少有的、真正从“数据如何喂给 AI”这个底层逻辑出发去重构的区块链。对于咱们这种不想在土狗堆里博运气、想看点长线逻辑的人来说,Vanar 提供了一个非常独特的观察视角。

在这个 AI 叙事被严重误读的时代,当所有人都在疯抢“铲子”(算力)时,去研究一下“矿图”(语义数据结构),说不定会有意想不到的收获。

下一步建议

既然咱们聊到了这儿,你要是有兴趣,别光听我说:

* 去领点测试币: 亲自去 Vanar 的 Vanguard 测试网走一圈,看看它的浏览器,对比一下它返回的数据格式跟以太坊有什么区别。

* 盯紧合作动态: 看看它说的那些主流游戏工作室、主流企业(比如之前传闻的某些时尚品牌)到底有没有真的在上面部署合约。@Vanarchain